ResNet

# Tag:

- Source/KU_ML2

toc test

ResNet(Residual Networks)

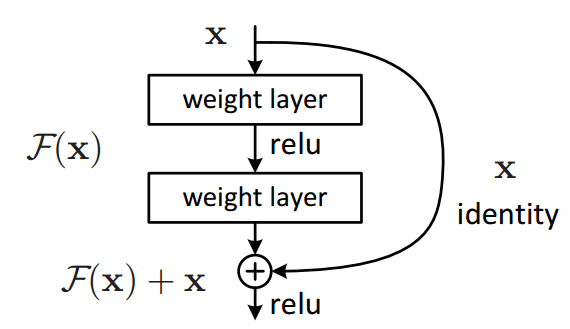

layer 사이의 skip connection을 두어서, 몇 레이어 이전의 output이 다시 input에 포함되도록 하는 구조의 Network.

몇 Layer 이전의 output이 다시 input으로 들어오게 되므로, 학습이 어느 정도 잘못 되더라도 복원이 가능하다고 할 수 있다.

개의 Layer이 이전의 output과, 바로 직전의 output이 합성되어 새로운 output 이 만들어진다. 이 때, 는 Activation Function이 되며, 는 보통 Indentity를 유지하기 위해 Identity Matrix를 이용해 입력이 그대로 들어가게 한다.

출력층의 결과를 라고 한다면, 이 때 는 Residual이라고 불린다.

라는 학습 결과를 후의 학습에 재활용하는 것이라 할 수 있는데, 를 제외하고 더 학습해야 하는 부분인 를 Residual(잔차)로 취급하는 것이다.

이 때, 학습이 진행됨에 따라 는 0에 가까워지고, 는 에 근접하게 된다. 즉, 학습의 목표는 Residual function 를 최소화하는 방식으로 진행된다.

Preventing Gradient Vanishing

Layer를 깊게 쌓게됨에 따라, Gradient Vanishing와 Gradient Exploding 문제가 종종 발생하고는 했다.

ResNet에서는, Residual을 이용해 이를 방지할 수 있다.

자세한 건 나중에~