SVM

# Tag:

- Source/SUNI_CCTV

- Source/KU_ML2

Support Vector Machine(SVM)

모든 점에 대하여 비교하는 것이 아니라, decision boundary에 가까운 일부분만 사용하므로 기존의 방식에 비하여 간단하다.

Motivation: Vapnik's principle,

- 복잡한 문제보다는, 간단한 문제에서부터 시작해 풀자는 것.

- decision boundary를 결정할 때 기존의 방식으로는, 인 posterior를 예측하기 위해 : Bayesian Decision방식을 사용했다. 하지만 이는 직접 decision boundary를 찾자는 바로 어려운 문제를 푸는 것과 같다.

- 이보다는, 쉽고 간단한 linear한 decision bounary를 이용해 문제를 해결하자는 것이 아이디어이다.

Support Vector로부터 가장 가까이 있는 점의 margin이 최소가 되는 그러한 decision boundary가 optimal hyperplane이라고 본다.

Advancement

이를 kernel trick이라 하며, 고차원으로 만들어주는 함수는 basis function이라 한다.

kernel trick

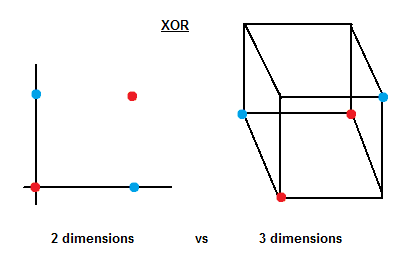

이렇게 새로운 양상을 이용해 저차원에서는 해결 불가능한 nonlinear 문제를, 고차원에서의 linear문제로 바꾸어 해결하는 일종의 trick이다.

- 이 때, 기존의 의 차원보다 커지게 되며, 위의 xor문제에서는 2차원에서 3차원으로 변한다.

- : 파란 점이 새로운 차원 상에서 위에 있게 되며, linear한 decision boundary를 그을 수 있다. 대신 를 넣어 계산한다.

Kernel

정확히는, 이를 kernel trick이라 한다. 이를 위하여, Support Vector를 계산할 때 Dual Problem으로 바꾸어 계산한다.

과 같은 kernel function 를 찾아 내적을 통한 빠른 계산을 할 수 있다.

gram matrix: 빠른 계산을 위하여, Kernel 함수의 경우에 대해 미리 계산하여 놓고 사용하기 도 한다.

예외 허용

이는 곧 Generalization으로 이어져, Overfitting이 발생하지 않도록 한다.